DeepSeek-r1 大模型使用

幕僚云已上架DeepSeek-r1-70b、DeepSeek-r1-32b云主机镜像。云主机镜像通过使用Ollama+OpenWebUI提供chat交互。

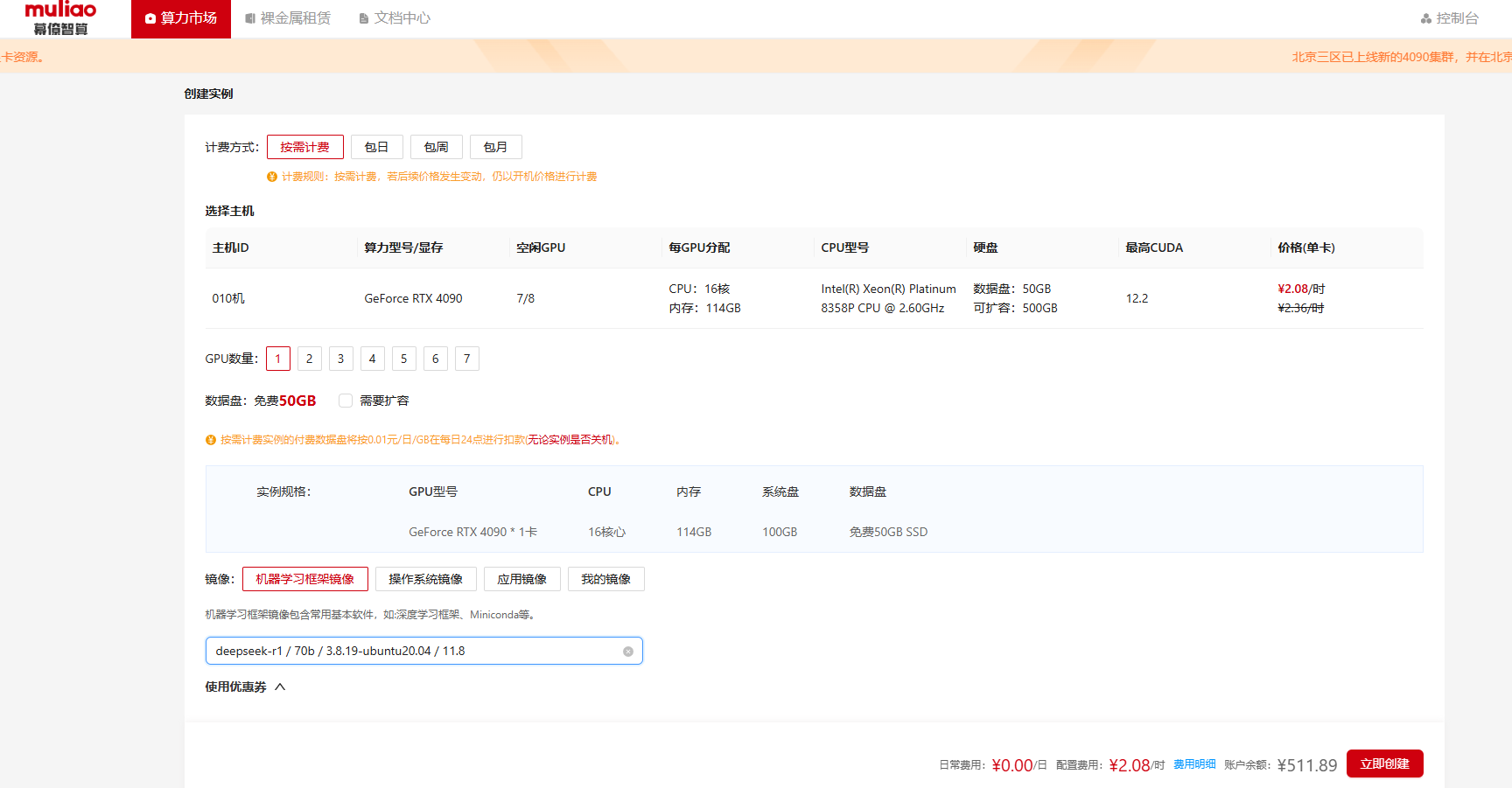

DeepSeek-r1-70b建议使用4至8卡(4090)云主机配置,DeepSeek-r1-32b建议使用2至4卡(4090)云主机配置。

Ollama是一个强大且易于使用的本地大模型推理框架,它专注于简化和优化大型语言模型(LLMs)在本地环境中的部署、管理和推理工作流。可以将Ollama理解为一个大模型推理框架的后端服务。

OpenWebUI是一个可扩展的、功能丰富的、用户友好的自托管Web界面,设计用于完全离线运行。它支持各种LLM运行器,包括Ollama和兼容OpenAI的API。

进入算力市场,选择DeepSeek镜像,点击【立即创建】即可,截图如下:

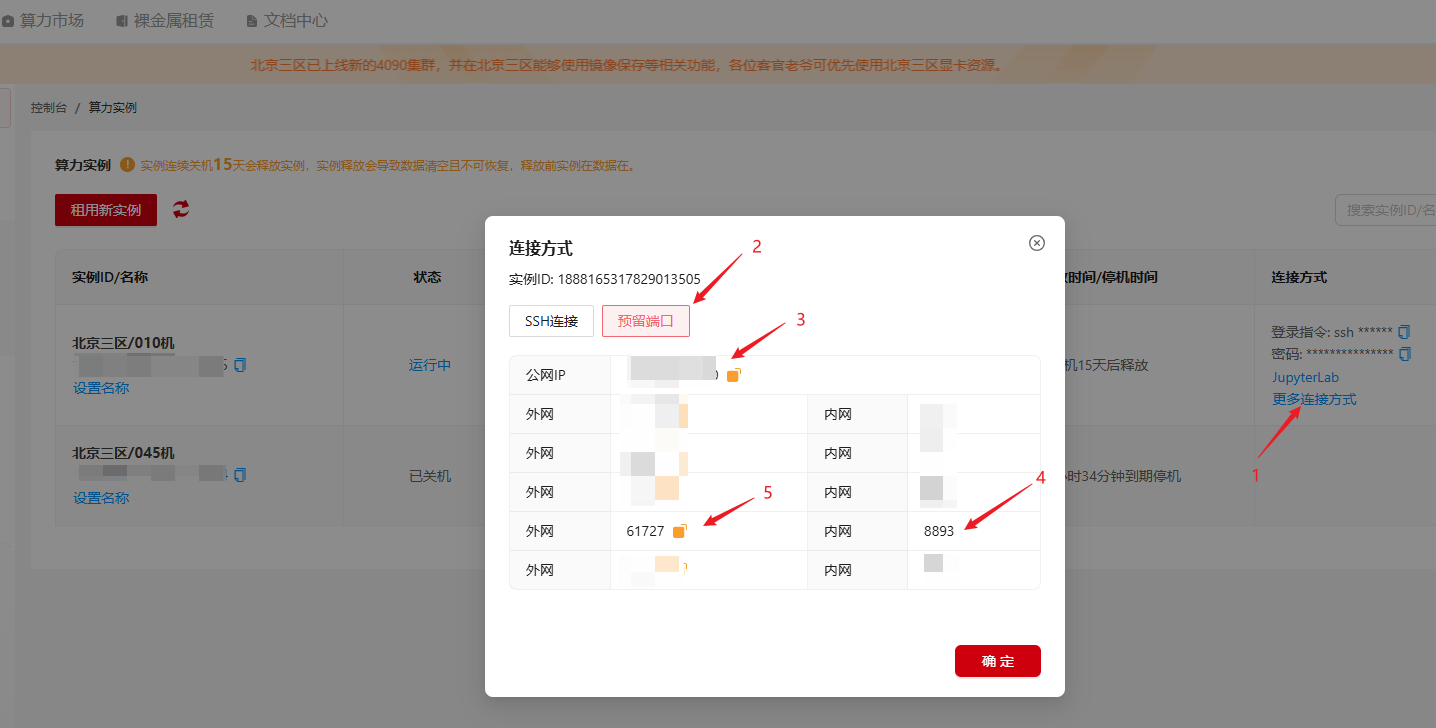

虚拟机创建完成后,页面会跳转至【控制台】-【算例实例】页面,查看更多连接方式。

云主机启动之后,Ollama与OpenWebUI服务会自启动,用户访问OpenWebUI,可以通过控制台【更多连接方式】-【预留端口】,OpenWebUI服务内部端口为8893,通过映射公网端口进行访问。如当前样例中,内部端口8893映射至61727,可使用外网IP:公网端口(即 http://ip_address:61727)进行访问(61727是内部端口8893映射的外部端口)。

OpenWebUI启动命令如下:

docker run -d -e AIOHTTP_CLIENT_TIMEOUT_OPENAI_MODEL_LIST=1 --network=host -v open-webui:/app/backend/data -e OLLAMA_BASE_URL=http://127.0.0.1:11434 -e PORT=8893 -e RAG_EMBEDDING_MODEL="" -e USE_CUDA_DOCKER=True --name open-webui --restart always ghcr.nju.edu.cn/open-webui/open-webui:v0.5.10

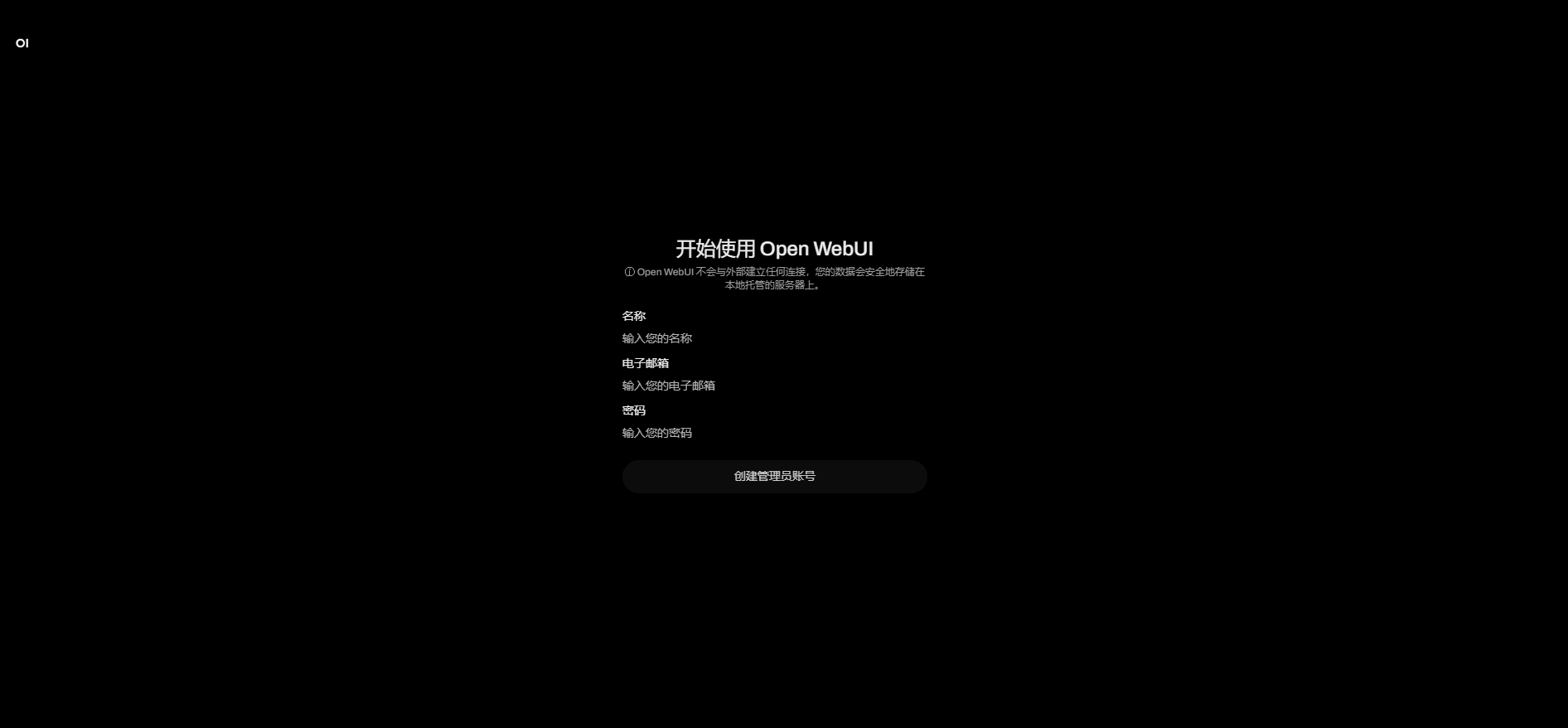

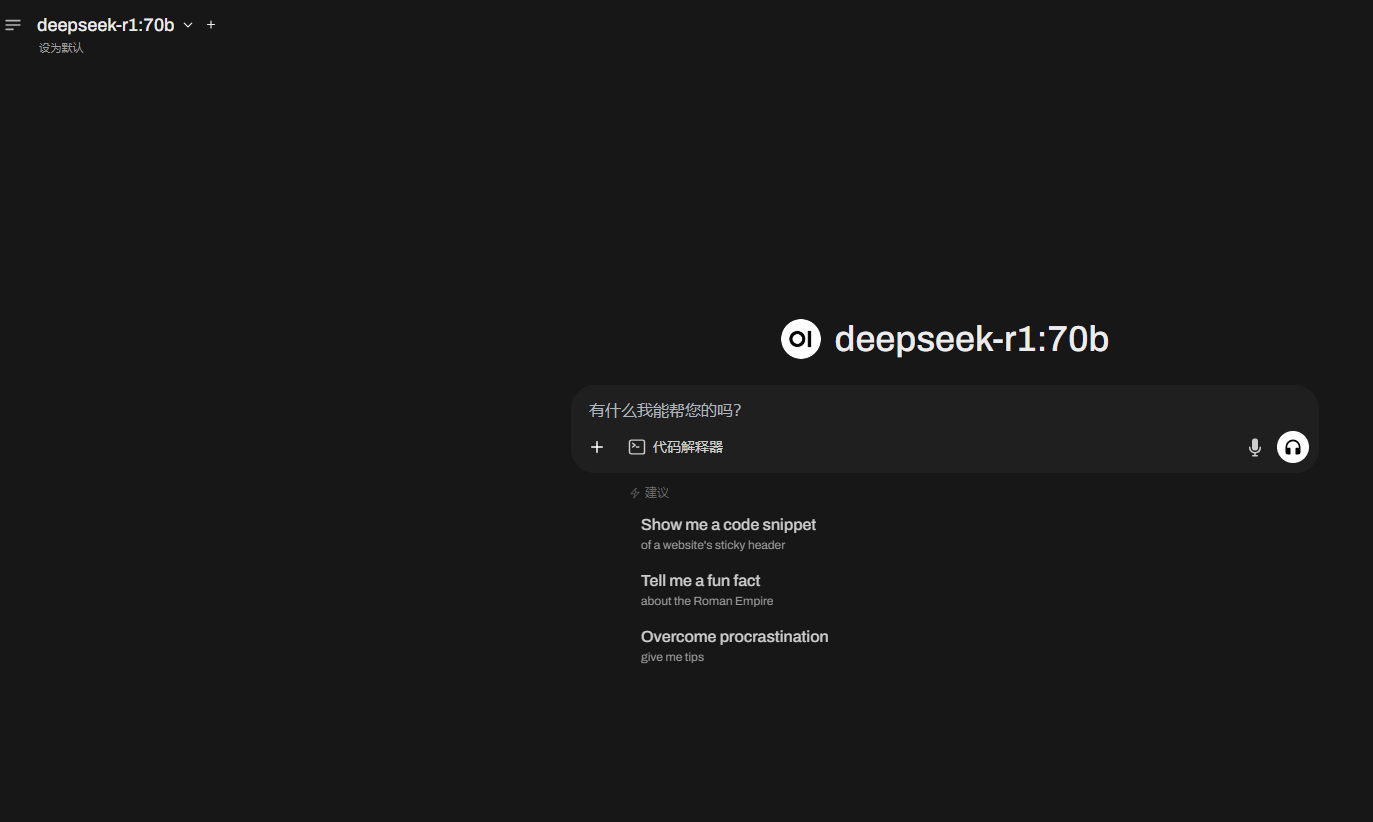

访问截图如下:

备注:服务启动首次登陆需要初始化部分数据,请耐心等待10~30秒,出现以上截图,点击【开始使用】创建用户

点击【开始使用】出现如下截图:

输入注册信息即可登录使用:

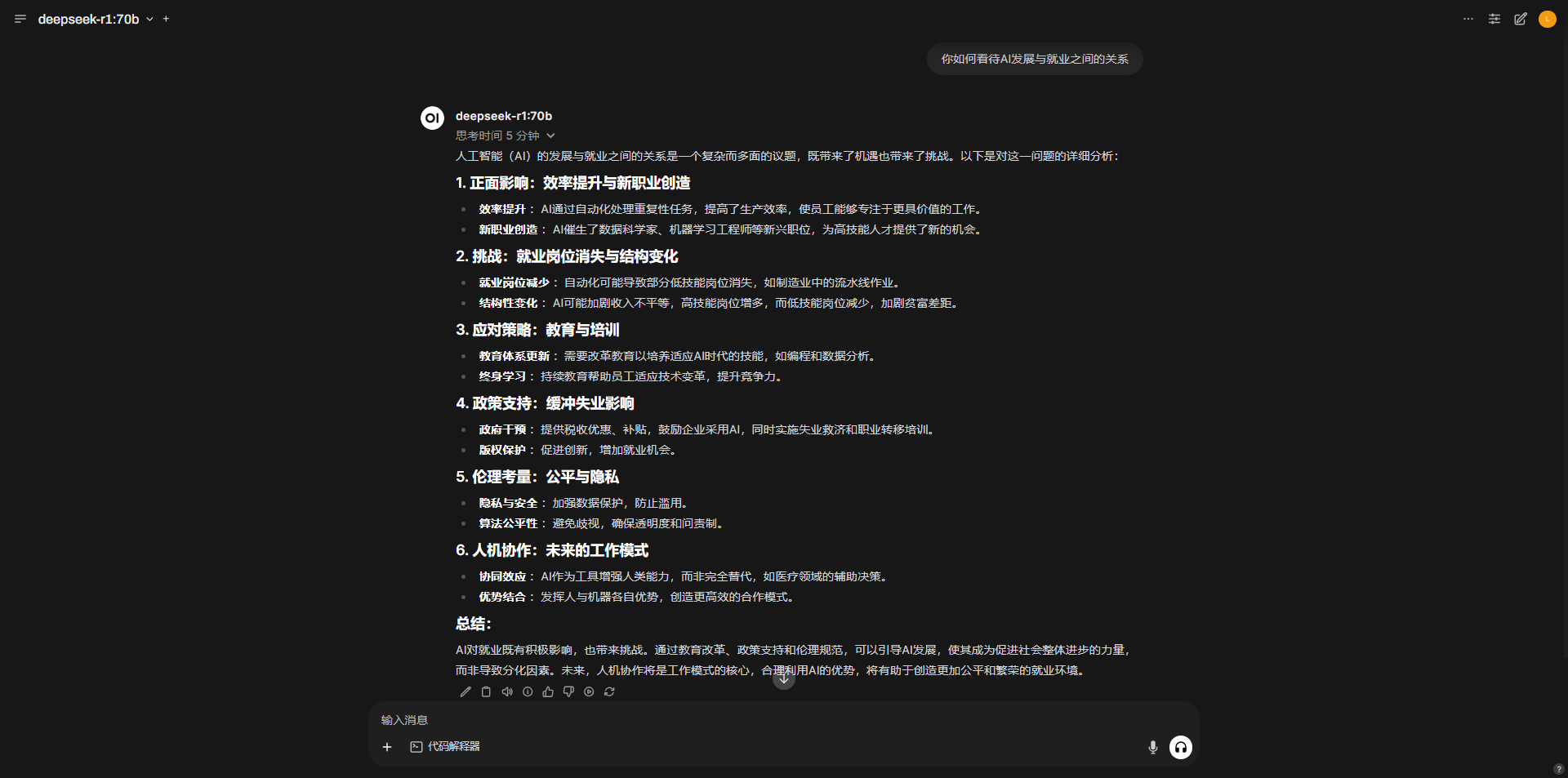

从交互窗口输入问题可以进行交互。enjoy !